今年以来,大模型的火热发展不仅让人工智能重回行业舞台中心,对于产业新一轮价值增长也提供了新势能。然而,随着大模型技术研发的深入,参数规模增长,也使得相关的计算资源需求的急剧增加,为大模型发展的新一轮突破带来了挑战。

因此,高算力芯片的需求变得更为迫切,这种需求不仅仅体现在模型训练和推理上,同时也延伸到了API调用等方方面面。拥有足够的算力资源,已经成为评估一个人工智能企业实力的硬指标之一。

近期,OpenAI的负责人山姆·奥特曼(Sam Altman)公开表示,尽管目前还在评估中,但OpenAI并不排除自研 AI芯片的可能性。除了可能的自研计划,OpenAI也为此投资了Cerebras、Rain Neuromorphics、Atomic Semi等颇具潜力的芯片初创公司,旨在更快、更廉价地生产芯片。

除了OpenAI外,人工智能企业的巨头,例如微软、谷歌、Meta等企业也在积极探索AI芯片的研发。一时之间,AI芯片相关的课题,又成为大模型广泛应用的“仰望星空”前,首先需要“脚踏实地”解决的问题。AI芯片核心技术自研箭在弦上

众所周知,随着“百模大战”的局面已然形成,大模型设计和实现上取得了显著进展,参数规模增长相关的计算资源需求的急剧增加,训练和推理所需的计算资源也呈指数级增长。然而,算力作为人工智能发展的三要素之一,现实世界中有限的计算资源,训练和推理过程变得更加耗时和昂贵。

从技术架构来看,AI芯片主要分为图形处理器(GPU)、现场可编程门阵列(FPGA)、专用集成电路(ASIC)、中央处理器(CPU)四大类。其中,GPU是较为成熟的通用型人工智能芯片,作为重要的计算资源在人工智能领域中发挥着关键作用。特别是GPGPU技术的应用,使得GPU在云端进行大模型训练算法时能够显著缩短训练时长,减少能源消耗,降低人工智能的应用成本。FPGA和ASIC则是针对人工智能需求特征的半定制和全定制芯片,原则上定制化程度越高,所能兼容的算法种类就越少,但进行AI加速时拥有更好的性能与更低的功耗。

大模型之家在《人工智能大模型产业创新价值研究报告》中指出,在全球算力市场中,英伟达作为高算力芯片的龙头企业,占据着领先地位。其A100、H100显卡适用于支持各种机器学习模型,具备强大的数据处理能力,使其成为目前主流的AI芯片。目前,全球GPU市场中英伟达占据近90%份额。

在生成式人工智能热潮所引发的强劲需求下,英伟达第二季度营收达135.1亿美元,同比增长101%,创下历史新高,净利润达61.88亿美元,同比暴涨843%。此外,英伟达首席执行官黄仁勋指出,全球已装设价值约1兆美元的数据中心,包括云、企业等领域,这一兆美元的数据中心正逐渐转向加速运算和生成式AI,也让数据中心业务收入103亿美元,同比增长170%,成为新的增长引擎。

虽然亚马逊、Meta、寒武纪、地平线等国内外科技巨头都推出过AI芯片,但从使用场景上更多是用于AI运算加速,即推理方面,这种自研芯片的优势在于可以大幅降低算力成本。

而在AI训练方面,英伟达凭借CUDA生态优势,在AI及高性能计算等核心技术领域,仍然具备一定的领先优势。

而AMD、谷歌等企业虽然分别采用兼容CUDA和自研TPU的方式切入AI芯片赛道,试图从AI训练需求中分得一杯羹,但两者本身性能相比于英伟达同时期GPU而言性能与功耗方面还有一定差距,因此在市场表现上只能算差强人意。

可以说,在英伟达因为AI赚得盆满钵满的现状之下,有的企业想要抢夺英伟达在AI算力上的蛋糕,也有的企业想要实现芯片自主,在实现软硬协同的同时,节约芯片成本。

在大模型技术的全球化竞争面前,芯片也将成为核心竞争力之一。10月18日,美国计划进一步收紧对华AI芯片出口管制,并将管制扩大至更多国家。据称,新规将取消芯片的通信速度限制,并将重点放在计算性能上,这将导致原本可以在中国市场销售的英伟达A800和H800芯片停售(halting sales)。这两款芯片是英伟达去年为符合美出口管制要求定制的产品。

而国内在GPU领域,虽然在图形处理性能上已经快步缩小与头部企业差距,但在GPGPU领域,在算力、端口性能、生态等方面仍然与巨头有着一定的差距,虽然短期内,国内AI芯片市场仍然需要奋力追赶,但从长期看来,这种竞争将推动我国积累和发展芯片核心技术,促使我们在全球芯片领域取得更大的成就。端侧人工智能推动芯片AI能力升级

大模型的“芯战”,不仅体现在大模型本身的开发上。随着分布式计算技术需求的不断普及,以及用户对于个人数据隐私需求的不断升级。如今,大模型在端侧的部署,也推动着智能设备在芯片方面拥有更高的AI能力。

在2023骁龙峰会期间,高通技术公司发布了骁龙 XElite、第三代骁龙8移动平台等芯片新品,骁龙X Elite是为AI专门打造的PC计算平台,支持在终端侧运行超过130亿参数的生成式AI模型。而第三代骁龙8移动平台NPU相比前代有98%的性能提升,模块支持独立供电,达到40%的能效提升。得益于端侧的算力提升,依靠本地大模型,就能进行生成式AI的交互。

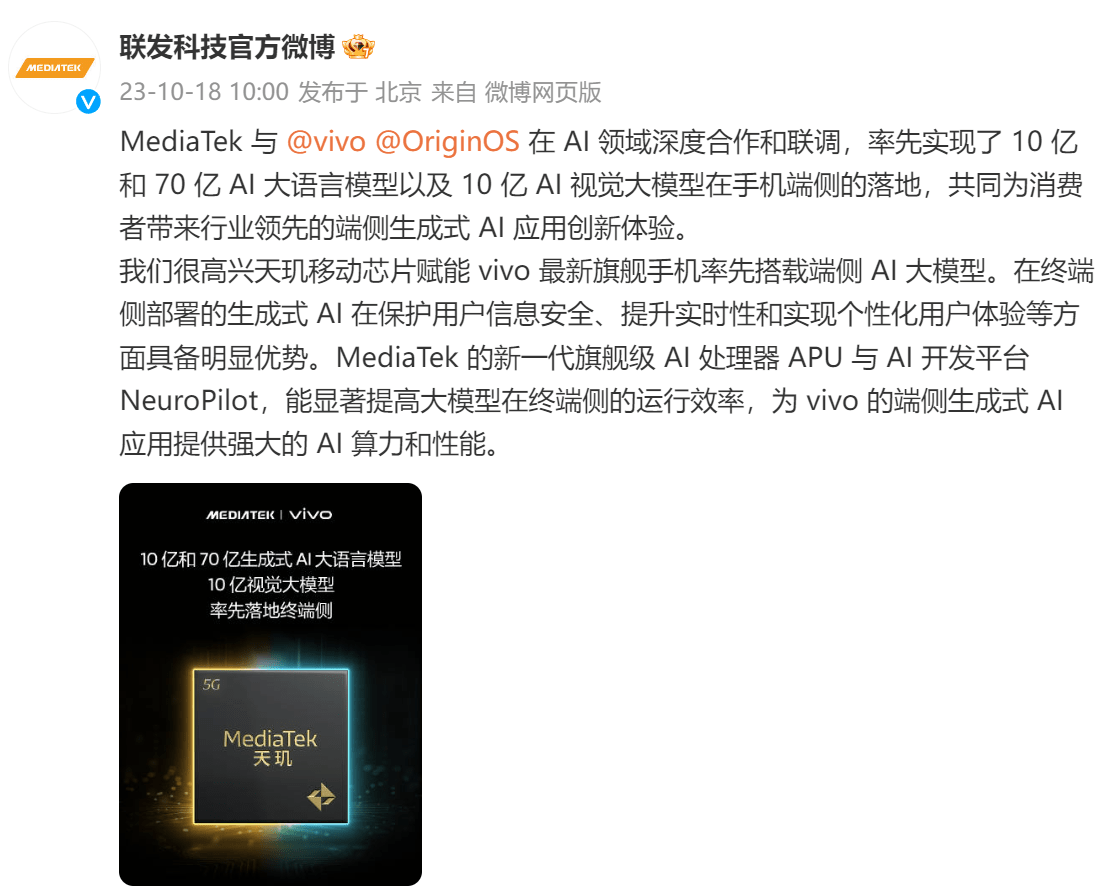

除此之外,联发科也在近期与vivo共同宣布,在行业内首次实现了手机上的10亿和70亿AI大语言模型,以及10亿AI视觉大模型,共同为消费者带来行业领先的端侧生成式AI应用创新体验,正是基于即将发布的天玑9300旗舰芯片和vivo X100系列。

在苹果上个月发布的iPhone 15 Pro系列所搭载的A17 Pro芯片中,搭载了16核Neural Engine神经网络引擎,运行速度比上代快2倍,每秒可处理多达35万亿次运算。这意味着A17 Pro能够更有效地执行复杂的AI任务,如深度学习、语音识别和图像处理等,从而提供更好的用户体验,为苹果的产品带来了更多的创新可能,如光线追踪、ProRes视频录制等功能。

同时,有消息称苹果公司也在扩大其AI工程师的招聘力度,并计划整合其各种服务和平台中的人工智能元素。苹果还同时在内部构建文本生成技术等任务,如长文本生成、摘要、问答等。

不只是手机产品,在PC产品线上,AI能力也成为了打造差异化卖点的重要方式。在上个月微软发布会上,不仅再次重提Copilot的无缝AI体验,在Surface产品线更新中,全新的Laptop Studio 2还成为配备独立英特尔NPU的Windows计算机。

可见,大模型在端侧的应用,未来或将成为手机、PC等智能设备的标配。一方面,本地部署的大模型,能够有效提升大模型处理的速度;另一方面,模型无需联网即可完成用户数据的训练,大大提升了数据安全的防护能力,让用户在使用时减少隐私信息泄漏的隐患。

在大模型之家看来,随着大模型在产业中全面落地已经成为不可阻挡的趋势,搭载大模型的智能设备将渗透你我工作与生活的方方面面。而作为算力的硬件载体,芯片必然将成为企业角力的焦点。

无论是在移动设备上,还是在云端数据中心,高性能、低能耗的芯片将成为各类智能应用的核心。面对日益庞大的大模型计算需求,各大科技企业纷纷亮出了自家芯片的底牌,希望在这场硬件竞赛中取得先机,而那些能够在芯片技术上取得突破的企业,将在人工智能领域占据重要地位,引领产业未来的发展方向。