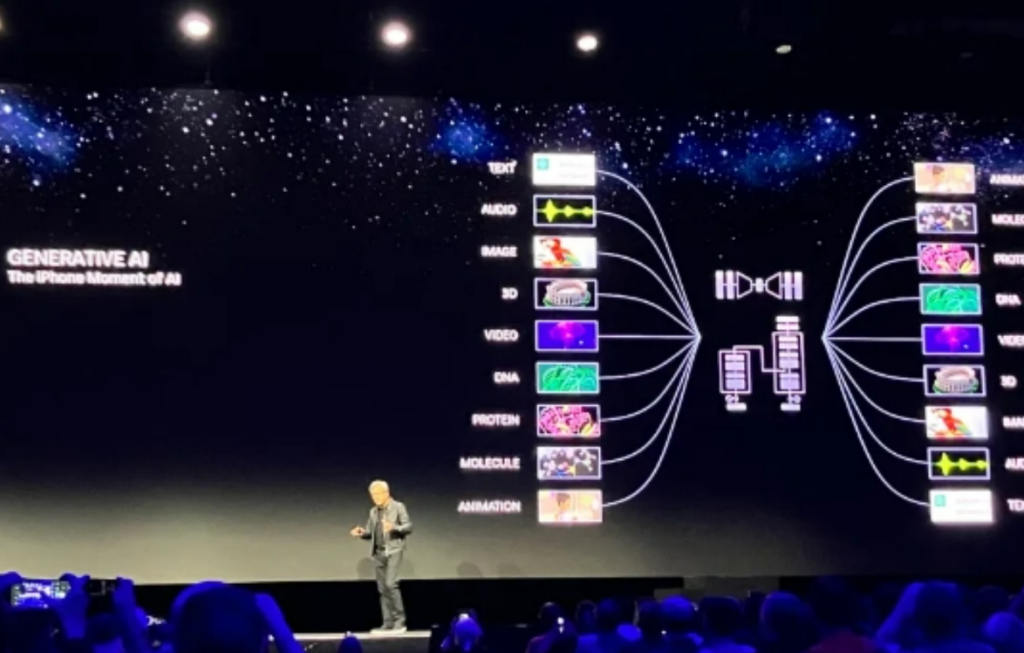

近来,人工智能聊天机器人ChatGPT始终是全球关注的热门话题,很多人认为AI将引发一场新革命。然而,ChatGPT的火爆离不开英伟达为其提供的“最强大脑”。事实上,早在十多年前,英伟达首席执行官黄仁勋就曾放言,英伟达的计算机芯片可以成为人工智能的“大脑”。如今看来,黄仁勋多年的坚持终于得到了回报,并帮助英伟达从电子游戏芯片制造商转型为人工智能领域的先驱。

8月9日,英伟达创始人兼首席执行官黄仁勋宣布了英伟达最新的超级芯片NVIDIA DGX GH200 Grace Hopper。

这块芯片搭载了全球最快的内存,不仅带宽每秒5TB,内存容量更是暴增接近50%来到141GB,并表示任何大语言模型都能运行。据预计,DGX GH200将于明年第二季度投产。

当天,黄仁勋曝光了用于生成式AI的GH200 Grace Hopper超级芯片、NVIDIA AI Workbench以及通过生成式AI和OpenUSD升级的NVIDIA Omniverse。

同时,黄仁勋还宣布英伟达与 AI 开源社区 Hugging Face 合作,将把生成式 AI 超级计算能力交付给数百万开发者,为他们构建大型语言模型(LLM)和 AI 应用提供支持。

黄仁勋表示,英伟达早在2018年做出了一项关乎生存的商业决策,很少有人意识到这个决策将重新定义英伟达的未来。而英伟达也得到了巨大的回报,但他认为,这只是人工智能驱动未来的开始。

黄仁勋认为,五年前的那个分水岭是选择以光线追踪和智能渲染的形式采用AI图像处理方式分别是RTX和DLSS。

“我们意识到光栅化已经达到了极限,”他指的是广泛使用的传统3D场景渲染方法。“2018 年是‘押注公司’的时刻。它要求我们重新发明硬件、软件和算法。在我们利用AI重塑CG 的同时,我们也在为AI重塑GPU。”

虽然光线追踪和DLSS仍处于在消费GPU和游戏领域采用的过程中,但因此而创建的架构被发现是与机器学习开发社区完美匹配的。

而对于训练更大更复杂的生成式模型所需的大量计算不是由具有一定GPU功能的传统数据中心来满足,而是由H100这样从一开始就设计用于大规模执行必要操作的系统。

可以公平地说,人工智能的发展在某些方面仅受到这些计算资源的可用性的限制。英伟达掀起了大规模的热潮,并尽可能多的销售了其所能生产的服务器和工作站。

黄仁勋坚信,这仅仅是开始。新的AI大模型不仅需要接受训练,还需要由数百万甚至数十亿用户定期实时运行。

“未来是LLM几乎是所有事物的前沿:“人类”是新的编程语言,”他说。黄仁勋认为,从视觉效果到快速数字化的制造市场、工厂设计和重工业,一切都将在某种程度上采用自然语言界面。

“整个工厂都将是软件定义的机器人,他们将制造的汽车本身也将是机器人,所以这是机器人设计的机器人建造机器人”他表示。

尽管这种观点似乎有道理,有些人可能不同意他的观点,但也恰好这对英伟达极其利好。

虽然对LLM依赖程度可能未知,但多数人认为将使用它以及需要对新的计算资源进行大量投资。当GH200(新推出的数据中心专用人工智能开发硬件)这样的东西可以以不到十分之一的成本完成同样的工作时,投资数百万美元在上一代计算资源(例如以 CPU 为中心的机架)将会被取代掉。

在会上,黄仁勋展示了多个Grace Hopper计算单元像乐高积木一样组装成一个刀片,然后是一个机架,一排GH200,所有这些都以如此高的速度连接在一起,相当于“世界上最大的单个GPU”,其中包括一个完整的ML专业计算能力。

他提出,这些将成为未来数字化、人工智能主导的行业的基本单元。

“我不知道这句话是谁说的,但是请记住未来属于加速计算,你买的越多,你省的就越多。如果我能要求你记住我今天演讲中的一件事,那就是它”黄仁勋说。

本次,黄仁勋并没有提及人工智能的许多挑战、监管或人工智能转变的整个概念。

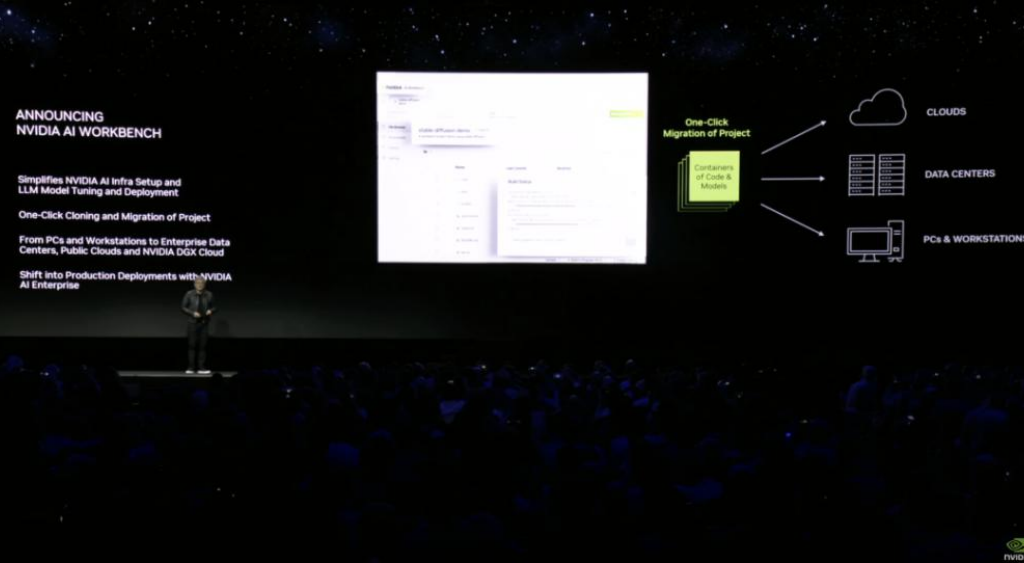

此外,为了加速各类企业定制生成式AI,黄仁勋宣布,英伟达推出AI Workbench。据介绍,它为开发人员提供了一个统一、易于使用的工具包,可以在个人电脑或工作站上快速创建、测试和微调生成式AI模型,然后将其扩展到几乎任何数据中心、公有云或NVIDIA DGX Cloud。

AI Workbench主要降低企业启动AI项目的门槛。通过在本地系统上运行的简化访问界面,它允许开发人员从流行库(如Hugging Face、GitHub 和NGC)中微调模型,使用自定义数据。然后,这些模型可以在多个平台之间共享。

“为了使这种能力普惠,我们必须使其能够在几乎所有地方运行。”黄仁勋称,“让所有人都能参与生成式AI。”

而在售卖硬件之外,在软件、云计算和平台以及生态方面,英伟达同样不遗余力,因为只有让生成式AI真正进入到工业生产和办公中,才算是真正实现“AI普惠”。