人工智能正在从文本、语音、视觉等单模态智能,向着多种模态融合的通用人工智能方向发展。“基于多模态的预训练大模型将成为人工智能基础设施”,这一观点已成为业内共识。建立统一的、跨场景、多任务的多模态基础模型正在成为人工智能研究的一个关键课题。未来,大模型作为基础设施,将实现图像、文本、音频统一知识表示,并朝着能推理、能回答问题、能总结、做创作的认知智能方向演进。

业内普遍认为,这得益于CLIP和BEiT-3的技术突破和广泛应用。

CLIP是OpenAI在2021年提出的跨模态模型,该模型专注于从文本特征映射到图像特征。通过在互联网上抓取大量图片文本,学习一段时间过后,CLIP能够实现用自然语言解释对图片的理解,也能通过文字描述来生成图片,这便是一种跨模态的生成和转换。之后火出圈的文生图大模型DALL-E 2,能够通过用户给的一段文字描述生成图片,其背后的技术基础正是CLIP模型。Stable Diffusion也使用了CLIP,实现通过文本提示调整模型,并借助扩散模型改善图像质量的目的。

图:CLIP 流程的三个阶段

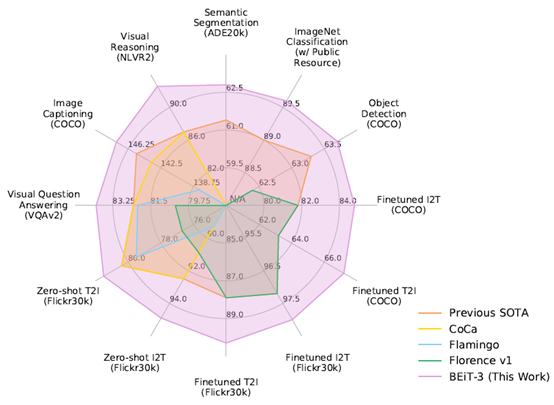

BEiT-3是微软亚洲研究院联合微软图灵团队在2022推出的多模态基础模型,该模型在视觉-语言任务处理上具备出色表现,包括目标检测、实例分割、语义分割、图像分类、视觉推理、视觉问答、图片描述生成和跨模态检索等。BEiT-3通过统一的模型框架和骨干网络建模,能够更加轻松地完成多模态编码和处理不同的下游任务,为多模态研究打开了新思路。

图:截至2022年8月,BEiT-3 在广泛的视觉及视觉-语言任务上都实现了 SOTA 的迁移性能

此外,引发科技界军备竞赛的ChatGPT大家已不陌生,它是在GPT-3.5上改进得来,据最新消息,其升级版GPT-4也已推出,特点是支持多模态应用,带来与之前完全不同的可能性。这意味着GPT-4有可能不仅可以管理不同语言数据的输入和输出,也能够做到输出图像甚至视频。

科技巨头和明星科技企业逐步强化其大模型对多模态的支持,使得外界对模型潜力的预期进一步强化,原因在于多模态感知是建立通用人工智能(AGI)的重要一步,建立多模态大模型则成为迈向通用人工智能的重要途径,也是解决人工智能应用落地所面临的需求碎片化、多样化等长尾问题的有效解决方式。

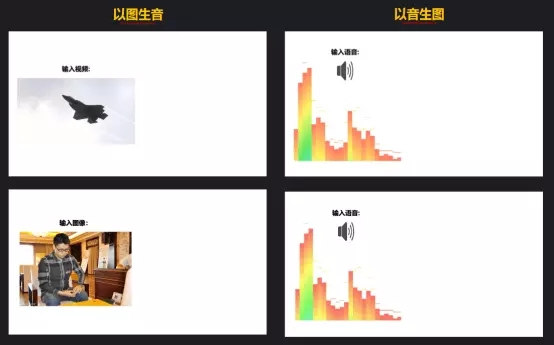

在国内,不久前,中科院自动化所宣布发布全球首个三模态大模型——紫东.太初,能够实现图文音语义的统一表达,将视觉、文本、语音三种模态统一起来,实现图文音跨模态理解与生成能力,可轻松完成以文搜图、以图生音、智能问答、图片生成、视频理解与等任务,这些能力将在工业质检、影视创作、互联网推荐、智能驾驶等领域得到应用。

图:紫东太初图片、语音跨模态生成演示

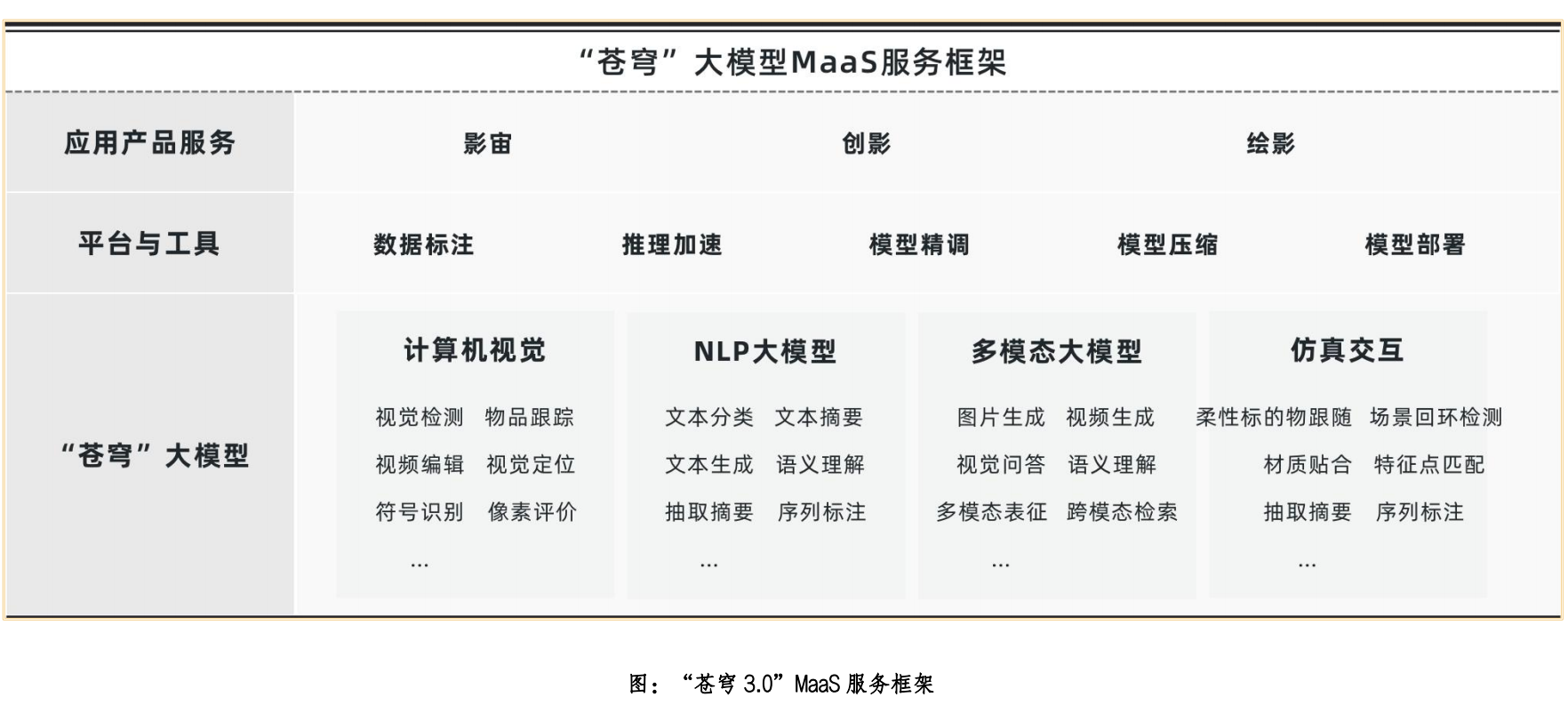

专注于智能视觉生产的技术企业影谱科技,近期对其多模态模型“苍穹”进行全面升级,从早前支持“图片-视频”、“文本-视频”、“语音-视频”的基础模型架构,升级为覆盖文本、图像、音频、视频、3D模型、触觉等跨越更多模态的内容理解和转换生成的产业级大模型。据悉,升级后的“苍穹3.0”大模型拥有丰富的视觉物料库、高效的视觉融合能力、精准的特征提取能力、多业务场景适应能力,在多模态预训练、平台服务、落地应用等方面实现突破。其图文音视频等多种跨模态开放任务处理能力可为元宇宙会展、智慧媒体、智慧科教、智慧文娱、数字商业等通用场景任务提供AI感知、理解和数字内容生成能力支持,助力产业对其存量市场进行全面盘活,催生孵化数字新业态、新模式,实现提质降本增效,同时拓展数字增量市场。

图:影谱科技“苍穹3.0”支持的AI作画产品

事实上,在早期对于 AI 和深度学习算法的探索中,科研人员大多专注于研究单模态模型,并利用单一模态数据来训练模型。例如,基于文本数据训练自然语言处理(NLP)模型,基于图像数据训练计算机视觉 (CV) 模型,使用音频数据训练语音模型等等。然而,在现实世界中,文本、图像、语音、视频等形式很多情况下都不是独立存在的,而是以更复杂的方式融合呈现,因此在人工智能的探索中,跨模态、多模态也成了近几年业界研究的重点。

业内人士分析称,多模态预训练模型集成语音、文本、图像、视频等各个模态信息的处理模式,更加贴近人类感知,也具有更高的社会价值和商业前景。

多模态预训练模型的发展将重塑人工智能商业模式,并为人们的生产生活方式带来积极影响。对个人而言,类似CLIP的多模态模型,将使更多非技术出身的人能够表达自己的创造力,无需再借助工具和编程专业能力。对企业来说,多模态预训练模型将成为企业生产效率提升的关键。商业模式上,具备大数据、算力资源和模型开发能力的科技企业,将会成为模型服务的提供方,帮助企业将基础模型的能力与生产流程融合起来,实现效率和成本最优。