化妆术,被称作是亚洲“第四大邪术”,拥有着让人类“改头换面”的神奇力量。

人类世界里随意横行的“障眼法”,遇到人工智能后,依旧奏效吗?阿里巴巴的图像AI团队就曾做过一个实验:

他们邀请了一位仿妆达人通过化妆挑战支付宝的刷脸闸机。精心妆扮之后,她接连成为 “赫本”“紫霞仙子”“林黛玉”,然而这三次“整容”般的化妆术在 AI 面前依然失效了—— 闸机以 100%的准确率全部成功识别。

为什么让人类肉眼无法辨别的化妆术在AI面前就原形毕露?这是因为AI与人类之间有着完全不同的认知逻辑。

不解风情的AI,天生自带“卸妆水”

我们都知道计算机使用二进制进行存储和运算,计算机对图片的理解也不例外。人类在大千世界里看到的纷纷扰扰,在计算机的眼里最后都会变成简单的“0”和“1”。

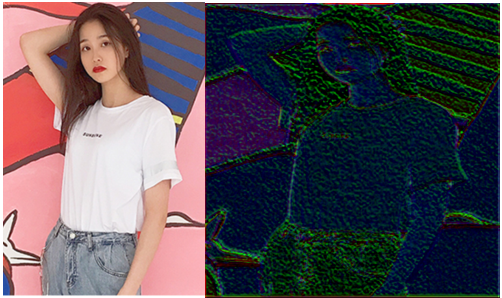

以下面这张美女图为例,计算机以 RGB 通道的方式理解图片,RGB 可以表现1677万种颜色,使得AI能够直观的感知图片中的细节变化。

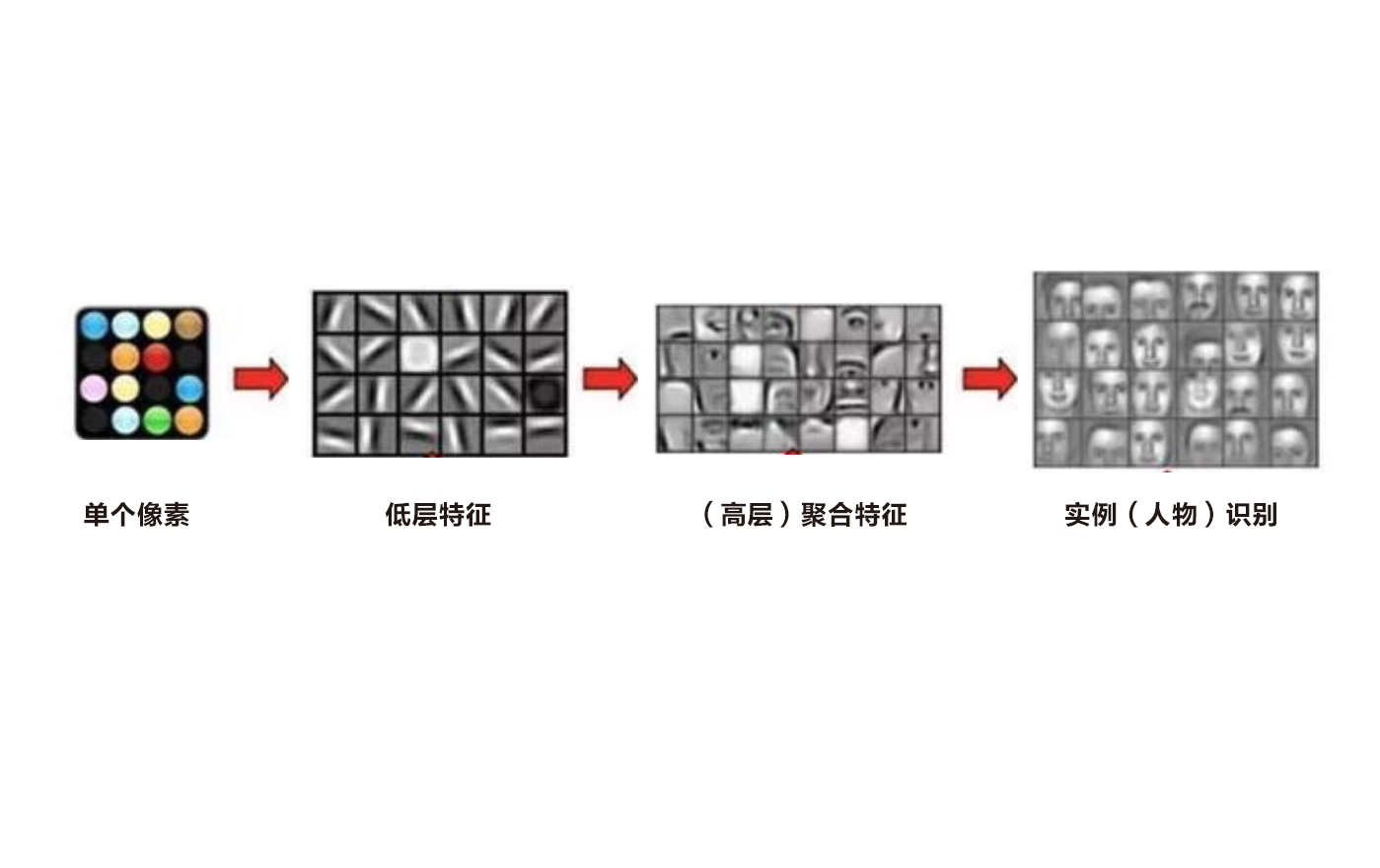

接着AI 会从每个像素开始去理解,不同部位之间的边缘过度和明暗变化等特征,例如发现人的眉眼边界,肤色明暗变换。

然后运用统计的方法对低层特征进行组合重绘,形成更高层次的特征,把人脸的某个特质部位或者整张人脸勾勒出来,最后完成快速比对。

整个过程中,每一步都建立在数字的基础上,每一步AI都像是个“冒得感情”的数学高手。细挑的柳叶眉、性感的大波浪,含羞的咬唇妆……这些人类眼中千姿百态的美,在 AI 看来,也不过在数值大小存在差异的数字而已。

两张图的比对,颜值爆表的女神和相貌平平的路人,最终AI这里并不会有太大区别

而“化妆术”本质是人类对色彩的灵活运用,并没有改变人类脸部的关键特征,因而很难逃过AI 的双眼。

这样的一种极简主义的表达,在人类看来不免略显残酷。然而就是在这样简单直接的理解之上,科学家们所设计的深度学习模型在识别率上才得以超越人类。

在应用领域,阿里巴巴研发的图像AI——拍立淘,目前已经可以识别超过100万种实体,建成了世界最大的商品图搜系统。

也许有人会诧异,别说100万种实体,就算是1万种,记忆高手也很难记全,AI又是如何做到的?

秘诀在于AI有着人类难以望其项背的三大能力:

- 更广泛的认知来源。一般来说,人类只能通过周围环境和社交活动来获得新的认知,而通过大规模学习标注好的数据,AI 可以识别越来越多的实体,并且 “看”得越多,AI识别得越好。

- 更细致的认知能力。除非长时间观看,人类很难关注到单张图片的每个细节信息。而 AI 不会错过任何一个细节:每个像素点都会被平等地对待,每个像素点都得到相同的处理过程,每个像素点之间都会用相同的方法用于特征提取,最终形成一套可以被快速复制,支持高并发的实体识别系统。

3、更敏捷的认知迭代。AI能够不断根据新的数据调整自己,纠正已有偏差的参数,做到在整体所有图片上最好的识别效果。例如阿里的图像AI,就建成了可以支持以支持数十亿图片分类训练的超大平台。凭借集群化的大规模训练,AI甚至可以做到一日之内看完普通人类数十年内看到的景象。

这样循环往复的训练下,AI识别的实体数就能够超出人类的认知范围。

用了60年,AI才学会人类与生俱来的“天赋”

AI的这种能力不是生来就有的,甚至在计算机诞生之初,都不具备视觉功能。

对人类而言,“认人”似乎是与生俱来的本能:刚出生几天的婴儿就能模仿父母的表情,我们可以毫不费力地从照片中找到熟悉的面孔,即便是暗淡灯光下,我们仍能认出楼梯末端的朋友;

这让我们甚至难以意识到这是亿万年来进化而来的神奇能力:只凭极少细节就分辨彼此。

然而,计算机并没有几亿年的演化时间教它辨别色彩、轮廓和形状等特征。“认人识物”这项对人类而言轻而易举的能力,对计算机而言却是步步维艰。

世界上第一台照相机出现在1839年,在计算机诞生的20世级40年代,照相机已经成为了一种大众技术。但让计算机和照相机实现真正意义上的交融,却让人类科学家付出了10年努力。

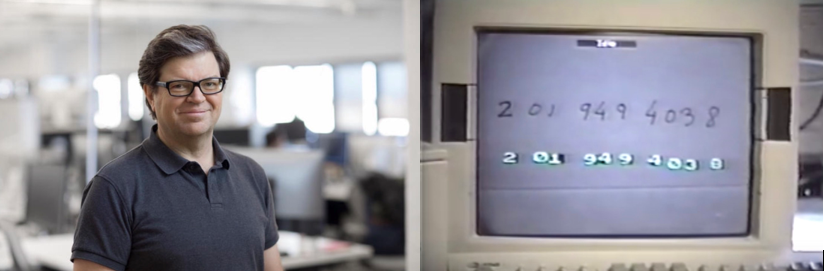

中间的鸿沟在于把图片翻译成计算机能理解的语言。直至1959年,计算机终于第一次“解码”了来自人类世界里的图像,美国科学家Russell研制了一台灰度处理器,可以把图片信息为二进制机器所理解的语言。

要让AI真正完成认知上的超越,仅给机器装上“眼睛”是不够的,还要赋予AI像人类一样的大脑。

这项工作的重大进展来自神经生物学的启发。1981年,神经生物学家大卫·休伯尔和托斯坦·维厄瑟尔发现人类视觉系统是一个分级的结构,人工智能科学家可以仿照人类大脑的认知结构,以人造神经元作为神经细胞,用不同方式连接的神经元代替不同的视皮层区域,以此赋予AI像人类一样的思考能力。

神经网络的发明,推动了视觉AI在2012年完成了革命性的突破。这年,搭载神经网络的AI ImageNet大规模视觉识别竞赛(ILSVRC)上一骑绝尘,首次在识别准确率上完成了对人类的超越。

至此,人类给计算机装上的这双“眼睛”终于有了媲美人类认知的能力,但识别万物只是计算机AI发展的第一阶段。

对于我们人类而言,视觉不仅仅是为了看见,而是为了对看见的事物做出反应,更好地理解这个世界。因此,阿里科学家的也希望能够赋予计算机这样的能力。

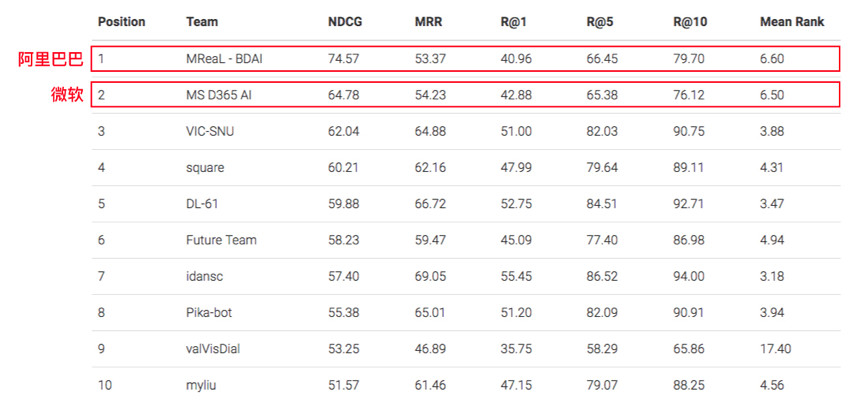

阿里图像AI正在加大投入对视觉对话方向的研究,这项技术需要综合集成图像识别、关系推理与自然语言理解三大能力。

它要求AI不仅能够有效识别图片里的实体以及它们之间的关系,还要推理出图片所描述的事件内容,同时顺畅与人类讨论,最终推动AI拥有对真实视觉世界的理解与推断能力。

前不久,谷歌运用1000块TPU重建了完整果蝇大脑神经图,整整40万亿像素,这是目前AI在神经元研究上的最新进步。

果蝇被作为试验动物,它的大脑神经元为10万个,而人类大脑的中的神经元多达1000亿个。在人类的大脑面前,目前的AI还只像个孩子。

回顾计算机视觉技术的重要突破,都来自于人类将自身能力成功的“复制”给了AI。人类越了解自身,就越能创造出更高级的AI。最终在AI强大的进化能力下,也会帮助人类扩展出新的认知。